В современном интернет-мире обеспечение безопасности и конфиденциальности важно не только для пользователей, но и для владельцев веб-сайтов. Ведь никто не хочет, чтобы его сайт был доступен для всех пользователей поисковых систем, искал по ключевым словам и привлекал нежелательное внимание. Одним из способов защиты вашего сайта является его закрытие от индексации и отображения в результатах поиска.

Основная причина закрытия сайта от поисковых систем — это сохранение конфиденциальности информации. Если сайт содержит личные данные пользователей или компании, чувствительную информацию или коммерческие секреты, владелец может захотеть предотвратить доступ к ней третьих лиц. Закрытие сайта также может быть полезно в случае, если вы работаете над разработкой сайта и хотите предотвратить его публичное отображение до окончания работ.

Существуют несколько способов закрытия сайта от индексации и отображения в результатах поиска. Один из наиболее распространенных способов — это использование специальных инструкций для поисковых роботов. Такие указания, известные как «файл robots.txt», размещаются в корневой директории сайта и содержат правила для поисковых систем. Например, вы можете запретить поисковым роботам индексировать всю вашу директорию или конкретные страницы.

Другой способ закрытия сайта — это использование мета-тега «noindex». Этот тег размещается на каждой странице сайта и сообщает поисковым системам, что данная страница не должна индексироваться. Этот метод особенно полезен в случае, если вам нужно закрыть только определенные страницы сайта, а не весь сайт в целом. Также можно использовать специальные HTTP-заголовки, чтобы указать поисковым роботам, что страница должна быть закрыта от индексации.

Правила игры в прятки: как закрыть сайт от индексации и отображения в результатах поиска

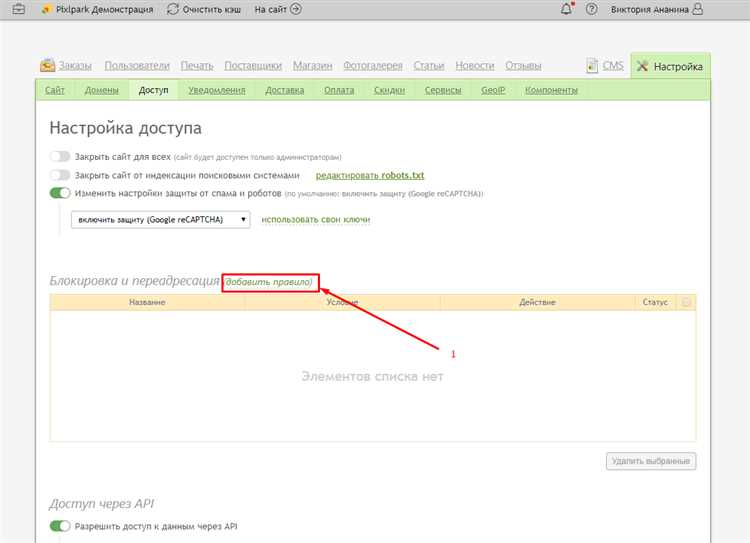

Иногда владелец сайта может захотеть временно или постоянно закрыть свой сайт от индексации и отображения в результатах поиска. Это может быть связано с различными причинами, такими как необходимость скрыть конфиденциальную информацию или временно приостановить работу сайта.

Для достижения этой цели существуют несколько способов, таких как использование файла robots.txt и мета-тега noindex. Файл robots.txt позволяет указать поисковым роботам, какие страницы сайта нужно индексировать, а какие — нет. Мета-тег noindex, который размещается в HTML-коде каждой страницы сайта, указывает поисковым системам, что данная страница не должна индексироваться.

Использование файла robots.txt

Для того чтобы закрыть сайт от индексации с помощью файла robots.txt, необходимо создать файл с именем «robots.txt» в корневой директории сайта. В этом файле нужно добавить директиву «User-agent: *» (которая указывает на всех поисковых роботов) и затем добавить директиву «Disallow: /» (которая запрещает индексацию всех страниц сайта). После этого необходимо загрузить файл на сервер.

Использование мета-тега noindex

Чтобы закрыть сайт от индексации с помощью мета-тега noindex, нужно добавить следующий код в раздел

каждой страницы сайта:<meta name="robots" content="noindex">

Таким образом, поисковые системы, сканируя сайт, увидят мета-тег noindex и не будут индексировать данную страницу.

Закрытие сайта от индексации и отображения в результатах поиска может быть полезным инструментом, но следует использовать его с осторожностью и только в случаях, когда это необходимо.

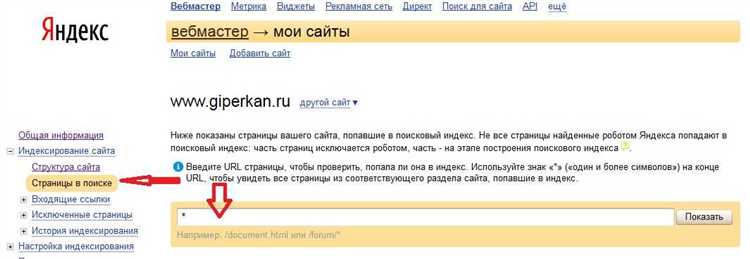

Использование robots.txt для исключения индексации

Для того чтобы исключить индексацию сайта поисковыми системами, можно использовать файл robots.txt. Этот файл предназначен для указания инструкций агентам поисковых систем о том, каким образом следует обрабатывать определенные страницы сайта.

Чтобы использовать файл robots.txt, необходимо его разместить в корневой директории сайта. Каждая инструкция в этом файле состоит из двух частей: директивы и значения. Директивы определяют, какую часть сайта нужно исключить из индексации, а значения указывают на конкретные страницы или папки.

Одна из наиболее часто используемых директив в файле robots.txt — это «Disallow». Если указать значение этой директивы, например «/private/», то поисковые системы исключат из индексации все страницы, находящиеся в этой папке. Таким образом, пользователь не сможет найти эту страницу через поисковую систему.

Отключение индексации отдельных страниц с помощью метатегов

При разработке сайта возникают ситуации, когда некоторые страницы не должны быть индексированы поисковыми системами. В таких случаях можно использовать метатеги, чтобы предотвратить индексацию и отображение таких страниц в результатах поиска.

Для этого необходимо добавить метатег «noindex» на нужную страницу. Данный метатег указывает поисковым системам, что страница не должна быть проиндексирована. Метатег нужно разместить внутри тега <head> перед закрывающимся тегом <head>.

Пример использования метатега «noindex»:

<head> <title>Заголовок страницы</title> <meta name="robots" content="noindex"> </head>

Таким образом, поисковые системы, обращаясь к данной странице, увидят метатег и не будут индексировать ее. Это может быть полезно, например, для страниц с конфиденциальной информацией, временных страниц, страниц с дублирующим контентом и других случаев, когда необходимо скрыть страницы от поисковых систем.

Закрытие сайта от поисковых роботов с помощью файла .htaccess

Для того чтобы закрыть сайт от поисковых роботов, необходимо добавить следующие строки кода в файл .htaccess:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} ^.*(название поискового робота) [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

В этом коде мы используем модуль mod_rewrite, чтобы перенаправлять запросы поисковых роботов. В строке «RewriteCond %{HTTP_USER_AGENT} ^.*(название поискового робота) [NC]» мы указываем название конкретного поискового робота или его часть, которому мы не хотим разрешить доступ к сайту. Ключевое слово [NC] указывает, что сравнение регистронезависимое.

С помощью строки «RewriteRule ^.*$ — [F,L]» мы запрещаем доступ для поискового робота, направляя его на пустую страницу (символ «-«). Ключевые слова [F,L] указывают на прекращение обработки правил .htaccess после данной строки.

Итак, использование файла .htaccess позволяет закрыть сайт от поисковых роботов и предотвратить индексацию и отображение в результатах поиска. Этот метод является эффективным способом защиты информации и контента сайта.